Innerhalb des Praktikums sollen Sie ein Data Warehouse erstellen, welches für Zitierungsanalysen wissenschaftlicher Publikationen nutzbar ist. Dazu wird im Folgenden zunächst Inhalt und Zweck von Zitierungsanalysen vorgestellt. Anschließend erfolgt eine Beschreibung der innerhalb des Praktikums verwendeten Datenquellen.

Zitierungsanalyse

Bei einer Zitierungsanalyse wird für wissenschaftliche Publikationen X die Anzahl derjenigen Publikationen Y bestimmt, die X zitieren. Diese Anzahl ist ein Indikator für den wissenschaftlichen Einfluss der Publikation X. Mit Hilfe der Zitierungszahl lassen sich sowohl einfache Rankings erstellen (Welche Publikationen wurden am häufigsten zitiert?) als auch komplexe Untersuchungen bezüglich Autoren, Institutionen, Venues (d.h. wo die Publikation erschienen ist) realisieren. Um einen Einblick in die möglichen Arten der Zitierungsanalyse zu erlangen, sei auf die Publikation Citation Analysis of Database Publications verwiesen, welche die Ergebnisse einer 2005 durchgeführten Zitierungsanalyse beschreibt.

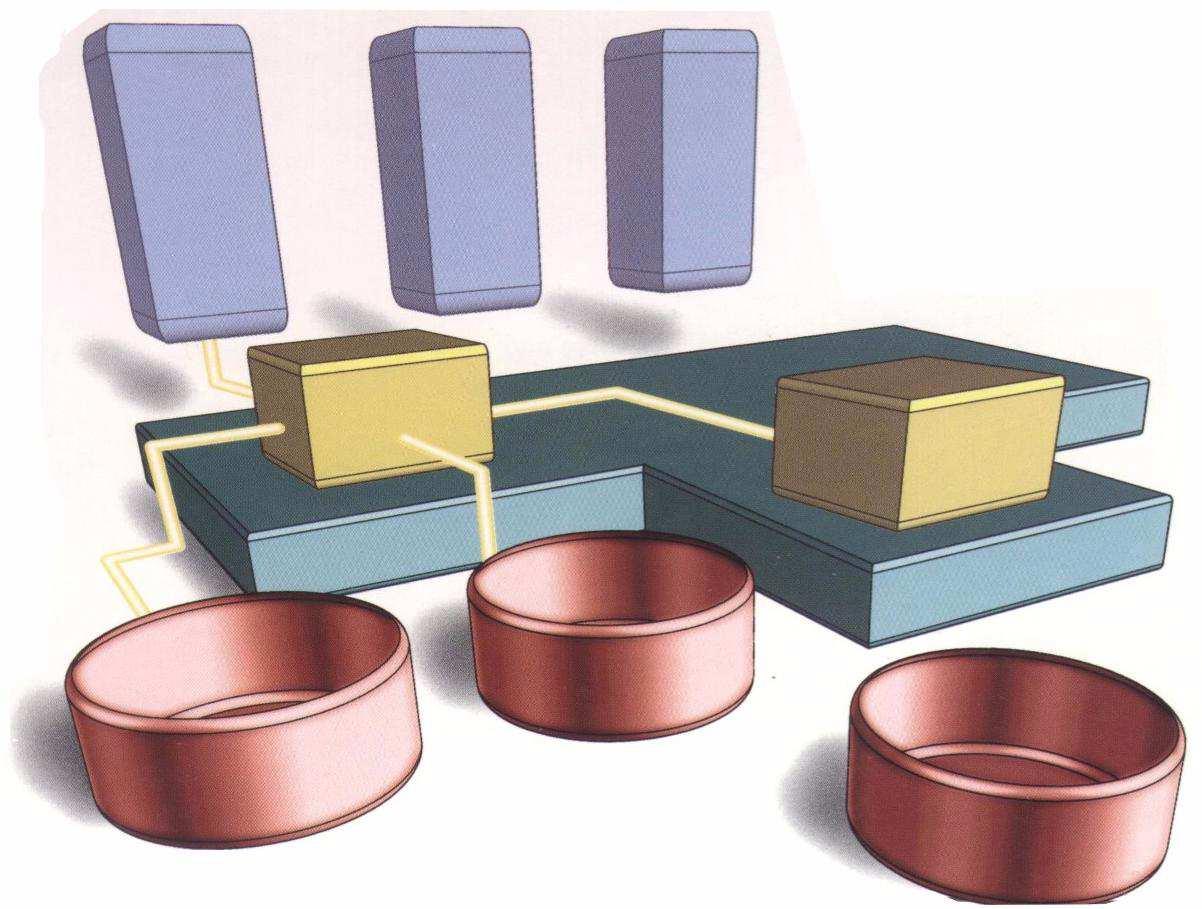

Die zugrundeliegende Miniwelt ist im folgenden ER-Modell illustriert.

Die Entitäten Autoren und Publikationen sind durch die N:M-Beziehung “hat Autoren” verbunden sind. Zusätzlich ist jede Publikation einem Venue zugeordnet, welchem wiederum mehrere assoziierte Publikationen durch die 1:N-Relation “erschienen bei” hat.

Datenquellen

Innerhalb des Data-Warehouse-Praktikums stehen Ihnen Daten der folgenden drei Datenquellen zur Verfügung:

- DBLP Bibliography ist eine manuelle gepflegte Website, die komplette Listen verschiedener Venues aus dem Informatik-Bereich enthält.

- ACM Digital Library ist das Portal der Association for Computing Machinery, welche die wissenschaftliche Gesellschaft für Informatik in den USA ist. Es enthält ebenfalls komplette Listen verschiedener Venues.

- Google Scholar ist eine Suchmaschine für wissenschaftliche Publikationen, welche nicht nur auf den Informatik-Bereich konzentriert ist.

Im Rahmen der Vorbereitung des Praktikums wurde eine ausgewählte Teilmenge der Daten heruntergeladen, die Ihnen in Form von CSV- und XML-Dateien im Verzeichnis \\informatik\pools\public\dwhprak\data zur Verfügung steht. Das Verzeichnis sollte als Netzlaufwerk eingebunden werden. In den folgenden Abschnitten werden sowohl Aufbau der Dateien als auch Eigenschaften der Datenquellen näher erläutert.

DBLP Bibliography (DBLP)

Der komplette Datenbestand von DBLP (Stand: Januar 2007) steht innerhalb mehrerer CSV-Dateien zur Verfügung. Die Felder der CSV-Dateien sind durch Tabulator getrennt. NULL-Werte, d.h. nicht definierte Felder, sind durch einen Leerstring charakterisiert. Die CSV-Dateien enthalten keine “Spaltenüberschriften”, so dass im Folgenden bei der Definition des Dateiaufbaus die Nummern der Spalten verwendet werden.

Author.csv(21MB)- Id

- vollständiger Name

- Vorname(n)

- Familienname

- URL der Homepage

Publication.csv(87MB)- Id

- DBLP-Code

- Titel

- Jahr der Veröffentlichung

- Startseite

- Endseite

VenueSeries.csv(0,1MB)- Id

- Name

- Typ (z.B. “Conference” oder “Journal”)

Author_Publication.csv(28MB)- Id der Publikation

- Id des Autoren

- Position des Autors in der Liste der Autoren (1=Erstautor, 2=Zweiautor, …)

VenueSeries_Publication.csv(9MB)- Id der Venue-Serie

- Id der Publikation

Die Datenqualität der DBLP-Datenquelle ist sehr hoch. Sie enthält keine Duplikate bei Publikationen und Venues sowie fast keine bei den Autoren. Beachten Sie, dass alle Ids nur innerhalb von DBLP eindeutig sind.

ACM Digital Library (ACM)

Für das Praktikum wurden die Publikationen von fünf Venue-Serien heruntergeladen. Es handelt sich um die beiden Konferenzen VLDB und SIGMOD sowie um die drei Journals ACM Transactions on Database Systems (TODS), VLDB Journal und SIGMOD Record. Das XML-File (ACM.xml, 20MB) beinhaltet eine Menge von Publikationen, deren XML-Struktur am folgenden Beispiel illustriert wird (XML-Schema in ACM.xsd).

Jede Publikation hat eine innerhalb der Datenquelle ACM eindeutige Id, welche als Attribut des Publication-Elements dargestellt wird. Jede Publikation hat weiterhin einen Titel sowie optional einen Link auf den Volltext (meist ein PDF-Dokument). Beachten Sie, dass das Trennzeichen für URL-Parameter (“&”) durch “& #38;” innerhalb des XML-Dokuments kodiert wird. Jede Publikation ist bei einem Venue erschienen, das entweder eine Konferenz oder (wie im obigen Fall) ein Journal ist. Jedes Venue gehört zu einer Serie (Konferenzreihe bzw. Journalname) und besitzt ein Erscheinungsjahr. Jede Publikation hat eine Menge von Autoren, die durch ihren Namen und optional durch ihre Institution gekennzeichnet sind. Zusätzlich ist die Position des Autors (Attribut “pos”) angegeben, d.h. ob es sich um den Erstautor, Zweitautor, usw. handelt. Für jede zitierende Publikation gibt es ein CitingPub-Element, dass aus einer Publikations-Id sowie einem Referenzstring besteht. (In obigem Beispiel sind aus Gründen der Übersichtlichkeit nur 3 Zitierungen aufgeführt.) Selbstzitierungen werden dadurch erkannt, dass mindestens ein Autor der Publikation auch Autor der zitierenden Publikation ist, was im Beispiel für die zweite Zitierung zutrifft.

Auch bei ACM ist die Datenqualität sehr gut, insbesondere gibt es auch keine Duplikate bei Publikationen und Venues.

Google Scholar (GS)

An die Suchmaschine Google Scholar wurden im Vorfeld eine Menge von Anfragen gestellt und die resultierenden Ergebnisse ebenfalls in einem XML-Dokument gespeichert (GS.xml, 35 MB), dessen Aufbau an folgendem Beispiel erläutert wird (XML-Schema in GS.xsd).

<Publication id="11767853031465773370"> <Title>A survey of approaches to automatic schema matching</Title> <NoOfCitings>690</NoOfCitings> <Additional>E Rahm, PA Bernstein - The VLDB Journal The International Journal on Very Large &hellip;, 2001 - Springer</Additional> </Publication>

Jede Publikation hat eine (wiederum nur innerhalb der Datenquelle eindeutige) Id und einen Titel. Die Anzahl der Zitierungen ist im Element “NoOfCitings” erfasst. Das Element “Additional” beinhalt die weiteren von GS ermittelten bibliografischen Daten, d.h. Autoren, Venue, Jahr, Herausgeber und weitere. (Dies entspricht der grünen Zeile, wenn Sie GS-Suchergebnisse auf der Website betrachten.)

Die Datenqualität von GS ist deutlich schlechter als bei DBLP und ACM. Durch den automatischen Extraktionsprozess (insbesondere auf Basis der Referenzlisten von im PDF-Format vorliegenden Publikationen) ergeben sich vielfältige Fehler (z.B. auf Grund von Tippfehlern in den erwähnten Referenzlisten) sowie hetereogene Schreibweisen, z.B. von Venue-Namen. Zusätzlich entstehen durch Fehler im Extraktionsprozess weitere Probleme, wie z.B. unvollständige Autorenlisten oder Zusätze im Titel. Dadurch enthält GS für eine Publikation i.A. auch mehrere Einträge (siehe Abschnitt Data Cleaning).